OpenAI propose désormais des modèles open-weight (“poids ouverts”) dont les poids (paramètres entraînés) sont librement téléchargeables marquant un retour vers plus d’ouverture dans la communauté IA.

Deux nouveaux modèles GPT « open source » disponibles chez OVHcloud

OVHcloud a annoncé la disponibilité immédiate de deux modèles de langage GPT‑OSS , en versions 20 milliards et 120 milliards de paramètres, via son service AI Endpoints. Il s’agit de modèles de Large Language Model (LLM) récents développés par OpenAI et rendus open source (dits open-weight car leurs poids sont publics). C’est un événement notable car OpenAI n’avait plus proposé de modèle aux poids ouverts depuis GPT‑2 en 2019. En les intégrant à AI Endpoints, OVHcloud permet aux développeurs européens d’accéder facilement à ces LLM de pointe via une simple API, hébergée dans un cloud souverain opéré en Europe. L’objectif affiché : démocratiser l’IA en combinant la puissance de GPT‑OSS avec la confiance d’une infrastructure locale respectueuse du RGPD.

Présentation de GPT‑OSS‑20B et GPT‑OSS‑120B

GPT‑OSS‑20B et GPT‑OSS‑120B partagent la même architecture de base, optimisée pour le raisonnement complexe et l’efficacité. Le suffixe indique le nombre de paramètres du modèle (20B = 21 milliards de paramètres, 120B = 117 milliards). Malgré ces tailles massives, ils utilisent une approche Mixture-of-Experts qui n’active qu’une fraction des neurones à chaque token généré (5,1 Mds sur 120B, 3,6 Mds sur 20B). GPT‑OSS‑120B se positionne comme un modèle haut de gamme : il obtient des performances proches du modèle propriétaire OpenAI o4-mini sur les benchmarks de référence en raisonnement tout en tenant sur un seul GPU de 80 Go. Il peut exploiter un contexte (historique de conversation ou document) allant jusqu’à 128 000 tokens, ouvrant la porte à des entrées très longues. De son côté, GPT‑OSS‑20B, bien que plus léger, reste très capable en compréhension et génération de langage. Avec ses ~21 milliards de paramètres, il fonctionne avec ~16 Go de mémoire : on peut donc envisager de l’exécuter en local, sur des serveurs modestes ou même des appareils embarqués, pour des usages embarqués ou déconnectés.

Cas d’usage : Ces deux modèles excellent en compréhension du langage, suivi d’instructions et raisonnement logique. GPT‑OSS‑120B sera privilégié pour des tâches complexes nécessitant le maximum de précision (analyse approfondie, assistants virtuels haut de gamme, agent décisionnel, etc.), tandis que GPT‑OSS‑20B, plus rapide et léger, suffira pour des besoins courants (chatbots multilingues, rédaction assistée, résumé de texte, etc.). Dans les deux cas, ils peuvent gérer du multilingue et produire du texte très cohérent, voire créatif, sur des sujets variés. OpenAI a également conçu ces modèles pour être “agentiques”, c’est-à-dire aptes à utiliser des outils externes (appels d’API, exécution de code) et à suivre des enchaînements de pensée (Chain-of-Thought) structurés. En pratique, cela signifie qu’ils peuvent servir de base à des assistants intelligents intégrant des fonctions avancées (par ex. interroger une base de connaissances puis raisonner sur le résultat, ou bien appeler une calculatrice externe si on leur pose un problème mathématique).

Différences entre 20B et 120B : outre la taille du modèle (et donc la qualité potentielle des réponses), la différence clé réside dans les besoins en ressources et le rapport performances/coût. GPT‑OSS‑120B, beaucoup plus volumineux, fournira généralement des réponses plus pertinentes et fines, surtout sur des tâches de raisonnement complexe ou avec très long contexte, mais au prix d’une consommation GPU et d’un temps d’inférence supérieurs. GPT‑OSS‑20B, moins coûteux à faire tourner, pourra répondre plus rapidement et être déployé dans des environnements contraints, avec une performance suffisante pour nombre d’usages courants. En résumé, on choisira le 20B pour sa légèreté et son coût réduit, et le 120B pour sa puissance maximale lorsque la qualité prime sur le coût.

Lexique : tokens, LLM de raisonnement, open-weight, inférence… c’est quoi exactement ?

-

Token : il s’agit de l’unité de texte manipulée par le modèle. Un token correspond à une portion de mot ou un caractère spécial. Par exemple, le mot « bonjour » peut être découpé en plusieurs tokens selon le modèle. Les modèles LLM comptent leurs entrées et sorties en tokens. C’est important car la facturation des services LLM (dont AI Endpoints) se fait généralement « au token » consommé. En français, on peut assimiler un token à environ ~0,75 mot en moyenne.

-

LLM de raisonnement : GPT‑OSS fait partie d’une nouvelle génération de LLM focalisés sur le raisonnement pas-à-pas (reasoning). Concrètement, ces modèles sont entraînés non seulement à produire du texte, mais à expliciter ou à suivre une chaîne de pensée pour arriver à une réponse. Cela les rend meilleurs pour les tâches complexes qui nécessitent plusieurs étapes de réflexion (par exemple résoudre un problème logique, effectuer une analyse scientifique, écrire du code en plusieurs étapes, etc.). On parle aussi de Reasoning LLM ou LLM agentique lorsqu’ils sont capables d’utiliser des outils externes pendant ce raisonnement.

-

Open-weight : ce terme indique que le modèle est ouvert, c’est-à-dire que ses poids (paramètres résultant de l’entraînement du réseau de neurones) sont publiquement accessibles. Toute personne peut donc télécharger le modèle complet et l’exécuter sur sa propre infrastructure, voire le re-entraîner (fine-tuning) sur des données spécifiques. C’est l’opposé d’un modèle fermée dont on n’accède qu’à l’API (ex: GPT-4 d’OpenAI). Open-weight rime avec open source dans la mesure où les modèles GPT‑OSS sont distribués sous licence Apache 2.0. L’intérêt ? Transparence sur le fonctionnement interne, possibilité d’audit, de personnalisation, et pas de dépendance forcée à un fournisseur cloud unique. OpenAI a néanmoins implémenté des garde-fous dans ces modèles (filtrage de contenus, etc.) pour réduire les risques d’usage malveillant, compte tenu de la puissance rendue publique.

-

Inférence : en apprentissage automatique, l’inférence désigne la phase où l’on utilise le modèle entraîné pour générer des prédictions ou des réponses, par opposition à la phase d’entraînement. Dans le contexte des LLM, faire de l’inférence revient à interroger le modèle avec un prompt et obtenir une réponse. On parle par exemple de serveur d’inférence pour décrire une instance déployée qui répond aux requêtes avec le LLM. Sur AI Endpoints, toutes les requêtes aux modèles sont des appels d’inférence (hébergés sur le cloud d’OVHcloud), facturés en fonction des ressources consommées (principalement le nombre de tokens traités).

Tarifs des modèles GPT‑OSS sur AI Endpoints d’OVHcloud

OVHcloud adopte une tarification à l’usage, proportionnelle au nombre de tokens d’entrée et de sortie traités par le modèle. Les coûts diffèrent selon le modèle choisi (plus le modèle est grand et gourmand en calcul, plus le token est onéreux). À ce jour, voici un ordre de grandeur des tarifs :

-

GPT‑OSS‑20B : ~0,20 $ par million de tokens d’entrée et 0,30 $ par million de tokens générés. Autrement dit, 1 000 tokens envoyés dans le prompt coûtent ~$0,0002, et 1 000 tokens générés en réponse ~$0,0003.

-

GPT‑OSS‑120B : ~0,35 $ par million de tokens en entrée et 0,75 $ par million en sortie. Ce modèle étant plus lourd, chaque token est plus coûteux. Par exemple, 1 000 tokens produits ~ $0,00075 (contre $0,0003 avec le 20B).

NB : Ces tarifs sont indicatifs et peuvent évoluer. Ils restent néanmoins très compétitifs comparés aux modèles propriétaires de taille équivalente – on est de l’ordre de quelques dixièmes de centimes par 1 000 tokens, là où GPT-4 par exemple coûte plusieurs centimes par 1 000 tokens. OVHcloud facture par tranche de token effectivement utilisé, sans forfait minimum, ce qui permet d’optimiser les coûts en ne payant que ce qui est consommé.

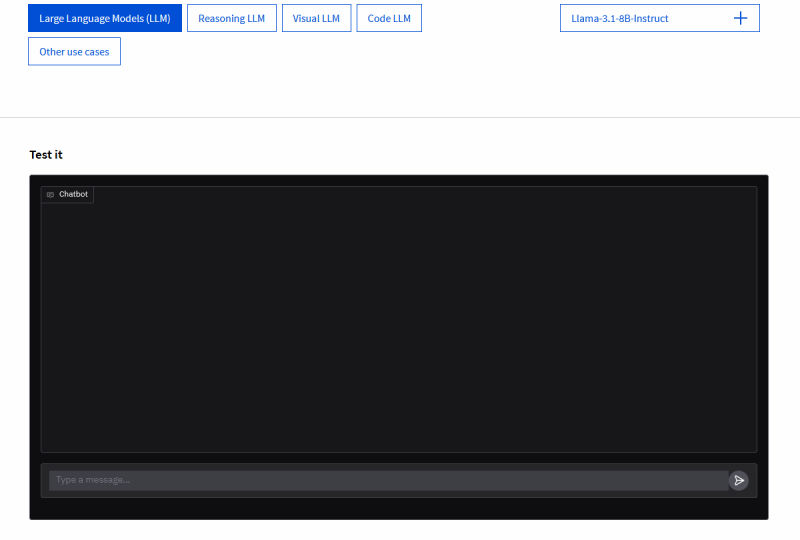

Essai gratuit : pour encourager les tests, OVHcloud propose un Playground web (bac à sable) où l’on peut essayer gratuitement les modèles avec ses propres prompts, afin d’en évaluer la pertinence. De plus, chaque nouveau client Public Cloud peut bénéficier d’un crédit gratuit de 200 $ à l’inscription, de quoi réaliser des milliers de requêtes d’inférence sans frais. En résumé, il est possible d’expérimenter GPT‑OSS‑20B et 120B sans payer un euro au départ, puis de passer en production et être facturé selon l’usage réel.

Un choix souverain : l’IA hébergée en Europe, alternative aux GAFAM

En ajoutant GPT‑OSS à son catalogue, OVHcloud renforce l’attrait d’une offre d’IA souveraine. Concrètement, toutes les requêtes et données transitent et restent dans des datacenters OVHcloud en Europe (notamment le datacenter water-cooling de Gravelines en France). Les données des utilisateurs ne quittent pas le sol européen, garantissant le respect du RGPD et la protection contre les réglementations extraterritoriales (telles que le Cloud Act américain). Pour les entreprises et organisations publiques, c’est un critère crucial : cela assure confidentialité, conformité et contrôle total sur les informations sensibles. OVHcloud insiste sur le fait que vos données ne sont jamais réutilisées pour entraîner les modèles, contrairement à certaines pratiques des grands acteurs, ce qui renforce la confiance.

Au-delà de la localisation des données, l’offre OVHcloud se pose en alternative européenne aux solutions des GAFAM. Plutôt que d’appeler une API OpenAI hébergée on ne sait où, les développeurs peuvent passer par AI Endpoints pour intégrer un modèle équivalent, avec des performances de pointe mais opéré par un acteur européen de confiance. Cela répond à une demande croissante d’autonomie stratégique : réduire la dépendance vis-à-vis des fournisseurs US tout en bénéficiant des dernières avancées de l’IA. OVHcloud, en tant que champion local du cloud, joue la carte de la transparence (catalogue 100% open-source) et de la réversibilité technologique : si besoin, les mêmes modèles open-weight peuvent être redéployés sur l’infrastructure de l’entreprise ou un autre cloud. Cette absence de vendor lock-in donne aux utilisateurs une liberté et une maîtrise accrues sur leurs solutions IA.

Synergie avec l’écosystème open-source et opportunités pour l’Europe

L’initiative d’OVHcloud s’inscrit dans la dynamique plus large de l’écosystème open-source en IA. En proposant GPT‑OSS-20B et 120B as-a-service, OVHcloud facilite l’accès à ces modèles libres sans exiger d’infrastructure GPU locale un développeur peut les tester et les intégrer en quelques appels d’API. Ceci profite aux startups et entreprises européennes qui souhaitent innover avec l’IA générative tout en gardant le contrôle technologique. Elles peuvent expérimenter rapidement sur AI Endpoints, puis éventuellement télécharger les poids open-source du modèle depuis HuggingFace pour un déploiement spécialisé on-premise si leur politique interne l’exige. C’est un pont entre le cloud public et l’open-source on-premise, offrant le meilleur des deux mondes (flexibilité du cloud et indépendance du code ouvert).

Par ailleurs, ces modèles open-source de haut niveau libérés par OpenAI ouvrent la voie à davantage de collaboration dans la communauté IA. Des organismes de recherche, universités ou entreprises européennes peuvent les affiner (fine-tune) sur des jeux de données locaux, dans des langues régionales, ou pour des domaines pointus, et partager ces variantes librement. On peut imaginer l’émergence de versions spécialisées (par ex. un GPT‑OSS-20B finement entraîné sur des données juridiques françaises, etc.), ce qui bénéficierait directement aux acteurs européens. OVHcloud, en hébergeant ces modèles dans AI Endpoints, agit comme un catalyseur de cette innovation distribuée : il connecte les dernières avancées open-source (GPT‑OSS, Llama, Mistral, etc.) aux besoins concrets des entreprises locales via une plateforme prête à l’emploi.

Enfin, d’un point de vue stratégique, le succès de solutions comme GPT‑OSS sur OVHcloud pourrait encourager d’autres initiatives open-source en Europe. On voit déjà des startups IA européennes (Mistral AI, Aleph Alpha, LightOn, etc.) travailler sur des modèles open alternatives. En consolidant une offre commerciale autour de modèles ouverts, OVHcloud montre que la voie d’une IA ouverte et souveraine est viable économiquement et performante techniquement. Cela augure d’un écosystème où l’Europe n’est pas condamnée à n’être qu’utilisatrice des modèles propriétaires US, mais peut contribuer et exceller dans le développement et l’hébergement de modèles d’IA de pointe.

Le catalogue AI Endpoints d’OVHcloud propose une large gamme de modèles couvrant tous les grands usages de l’intelligence artificielle. Côté LLM généralistes, on retrouve les nouveautés gpt-oss-20b et gpt-oss-120b d’OpenAI en open-weight, mais aussi des références comme Llama 3.1 (8B et 70B), Llama 3.3 70B, Mistral 7B, Mistral Small 3.2 24B, Mistral Nemo 2407, Mixtral 8x7B, ou encore DeepSeek-R1-Distill-Llama 70B. L’écosystème Qwen est également bien représenté avec Qwen3-32B, Qwen2.5-Coder-32B pour le code, et Qwen2.5-VL-72B pour la vision multimodale. Pour les usages plus spécialisés en traitement de texte, on trouve des modèles comme bart-large-cnn (résumé), t5-large (traduction), bert-base-NER (reconnaissance d’entités), bert-base-multilingual-sentiment (analyse de sentiments multilingue) et roberta-base-go_emotions (détection d’émotions).

Du côté de la voix, OVHcloud met à disposition Whisper (versions large v3 et large v3 turbo) pour la transcription multilingue, ainsi qu’une suite de modèles de synthèse vocale NVIDIA (nvr-tts en anglais, espagnol, italien et allemand). Pour la vision par ordinateur, on retrouve llava-next-mistral-7b pour le multimodal texte+image, ainsi que les modèles YOLOv11x dédiés à la détection et à la segmentation d’objets. L’offre inclut aussi des modèles d’embeddings et de recherche sémantique, comme bge-multilingual-gemma2, BGE-M3 et bge-base-en-v1.5. Enfin, pour la création visuelle, le modèle stable-diffusion-xl-base-v10 est proposé pour la génération d’images haute qualité.

Pour les curieux qui veulent s’amuser un peu ou travailler… c’est par là : https://endpoints.ai.cloud.ovh.net/models/gpt-oss-120b